主要从事linux,云原生架构改造,服务网格,elk,python,golang等相关技术。

- ·

- ·

- ·

- ·

- ·

- ·

- ·

- ·

- ·

- ·

分类: 架构设计与优化

2015-04-19 17:08:17

yum install ipvsadm -y(注意这里需要先配置yum源)

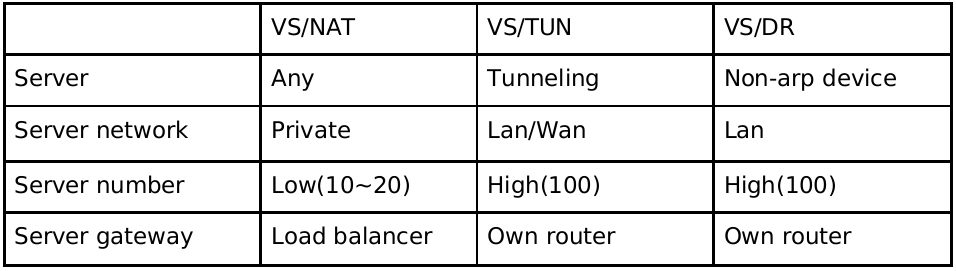

三种 ip 负载均衡技术的优缺点归纳在下表中:

注:以上三种方法所能支持最大服务器数目的估计是假设调度器使用 100m 网卡,调度器的硬件配置与后端服务器的硬件配置相同,而且是对一般 web 服 务。使用更高的硬件配置(如千兆网卡和更快的处理器)作为调度器,调度器所能调度的服务器数量会相应增加。当应用不同时,服务器的数目也会相应地改变。所 以,以上数据估计主要是为三种方法的伸缩性进行量化比较。

这里我在做的时候用了三台主机:

vm1 192.168.1.120 load balance eth0

vm1 192.168.1.188 load balance vip

vm2 192.168.1.121 realserver

vm3 192.168.1.122 realserver

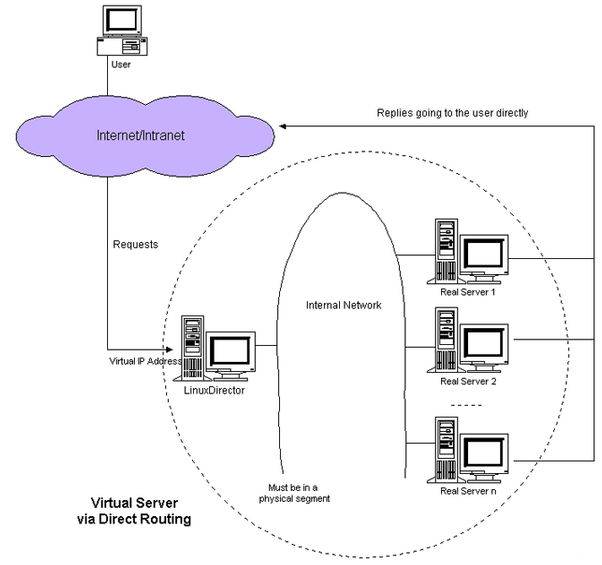

1.lvs-dr 模式(调度器与实际服务器都有一块网卡连在同一物理网段上)

简要的网络结构如下所示

配置lvs server

lvs_dr.sh

点击(此处)折叠或打开

- #!/bin/sh

- vip=192.168.1.188

- rip1=192.168.1.121

- rip2=192.168.1.122

- . /etc/rc.d/init.d/functions

- case "$1" in

- start)

- echo "start lvs of directorserver"

- #set the virtual ip address

- /sbin/ifconfig eth0:1 $vip broadcast $vip netmask 255.255.255.255 up

- /sbin/route add -host $vip dev eth0:1

- #clear ipvs table

- /sbin/ipvsadm -c

- #set lvs

- /sbin/ipvsadm -a -t $vip:80 -s rr

- /sbin/ipvsadm -a -t $vip:80 -r $rip1:80 -g

- /sbin/ipvsadm -a -t $vip:80 -r $rip2:80 -g

- #run lvs

- /sbin/ipvsadm

- ;;

- stop)

- echo "close lvs directorserver"

- /sbin/ipvsadm -c

- /sbin/ifconfig eth0:1 down

- ;;

- *)

- echo "usage: $0 {start|stop}"

- exit 1

- esac

realserver.sh

点击(此处)折叠或打开

- #!/bin/bash

- vip=192.168.1.188

- local_name=50bang

- broadcast=192.168.1.255 #vip's broadcast

- . /etc/rc.d/init.d/functions

- case "$1" in

- start)

- echo "reparing for real server"

- echo "1" >/proc/sys/net/ipv4/conf/lo/arp_ignore

- echo "2" >/proc/sys/net/ipv4/conf/lo/arp_announce

- echo "1" >/proc/sys/net/ipv4/conf/all/arp_ignore

- echo "2" >/proc/sys/net/ipv4/conf/all/arp_announce

- ifconfig lo:0 $vip netmask 255.255.255.255 broadcast $broadcast up

- /sbin/route add -host $vip dev lo:0

- ;;

- stop)

- ifconfig lo:0 down

- echo "0" >/proc/sys/net/ipv4/conf/lo/arp_ignore

- echo "0" >/proc/sys/net/ipv4/conf/lo/arp_announce

- echo "0" >/proc/sys/net/ipv4/conf/all/arp_ignore

- echo "0" >/proc/sys/net/ipv4/conf/all/arp_announce

- ;;

- *)

- echo "usage: lvs {start|stop}"

- exit 1

- esac

2.lvs-tun 模式

简要的网络架构如下:

配置lvs server

lvs_tun.sh

点击(此处)折叠或打开

- #!/bin/sh

- # description: start lvs of directorserver

- vip=192.168.1.188(注意,lvs server那台机器2个ip,一个是vip,一个是本身ip例如192.168.1.120)

- rip1=192.168.1.121

- rip2=192.168.1.122

- #ripn=192.168.0.n

- gw=192.168.1.1

- . /etc/rc.d/init.d/functions

- case "$1" in

- start)

- echo " start lvs of directorserver"

- # set the virtual ip address

- /sbin/ifconfig tunl0 $vip broadcast $vip netmask 255.255.255.0 up

- /sbin/route add -host $vip dev tunl0

- #clear ipvs table

- /sbin/ipvsadm -c

- #set lvs

- /sbin/ipvsadm -a -t $vip:80 -s rr

- /sbin/ipvsadm -a -t $vip:80 -r $rip1:80 -i

- /sbin/ipvsadm -a -t $vip:80 -r $rip2:80 -i

- #/sbin/ipvsadm -a -t $vip:80 -r $rip3:80 -i

- #run lvs

- /sbin/ipvsadm

- #end

- ;;

- stop)

- echo "close lvs directorserver"

- ifconfig tunl0 down

- /sbin/ipvsadm -c

- ;;

- *)

- echo "usage: $0 {start|stop}"

- exit 1

- esac

配置real server

realserver.sh

点击(此处)折叠或打开

- #!/bin/sh

- # description: config realserver tunl port and apply arp patch

- vip=192.168.1.188

- . /etc/rc.d/init.d/functions

- case "$1" in

- start)

- echo "tunl port starting"

- ifconfig tunl0 $vip netmask 255.255.255.0 broadcast $vip up

- /sbin/route add -host $vip dev tunl0

- echo "1" >/proc/sys/net/ipv4/conf/tunl0/arp_ignore

- echo "2" >/proc/sys/net/ipv4/conf/tunl0/arp_announce

- echo "1" >/proc/sys/net/ipv4/conf/all/arp_ignore

- echo "2" >/proc/sys/net/ipv4/conf/all/arp_announce

- sysctl -p

- ;;

- stop)

- echo "tunl port closing"

- ifconfig tunl0 down

- echo 1 > /proc/sys/net/ipv4/ip_forward

- echo 0 > /proc/sys/net/ipv4/conf/all/arp_announce

- ;;

- *)

- echo "usage: $0 {start|stop}"

- exit 1

- esac

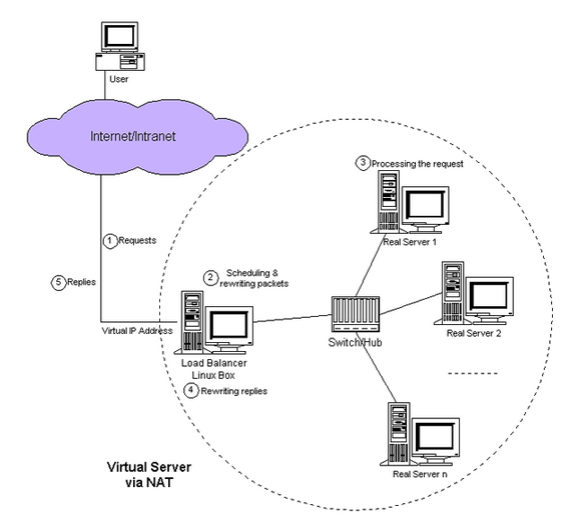

3.lvs-nat 模式

简要的网络架构如下图:

配置lvs server

lvs_nat.sh

点击(此处)折叠或打开

- #!/bin/sh

- # description: start lvs of nat

- vlan-ip=192.168.1.188

- rip1=10.1.1.2

- rip2=10.1.1.3

- #ripn=10.1.1.n

- gw=10.1.1.1

- . /etc/rc.d/init.d/functions

- case "$1" in

- start)

- echo " start lvs of natserver"

- echo "1" >/proc/sys/net/ipv4/ip_forward

- echo "0" >/proc/sys/net/ipv4/conf/all/send_redirects

- echo "0" >/proc/sys/net/ipv4/conf/default/send_redirects

- echo "0" >/proc/sys/net/ipv4/conf/eth0/send_redirects

- echo "0" >/proc/sys/net/ipv4/conf/eth1/send_redirects(内网卡上的)

- #clear ipvs table

- /sbin/ipvsadm -c

- #set lvs

- /sbin/ipvsadm -a -t $vlan-ip:80 -r $rip1:80 -m -w 1

- /sbin/ipvsadm -a -t $vlan-ip:80 -r $rip2:80 -m -w 1

- #run lvs

- /sbin/ipvsadm

- #end

- ;;

- stop)

- echo "close lvs nat server"

- echo "0" >/proc/sys/net/ipv4/ip_forward

- echo "1" >/proc/sys/net/ipv4/conf/all/send_redirects

- echo "1" >/proc/sys/net/ipv4/conf/default/send_redirects

- echo "1" >/proc/sys/net/ipv4/conf/eth0/send_redirects

- echo "1" >/proc/sys/net/ipv4/conf/eth1/send_redirects(内网卡上的)

- /sbin/ipvsadm -c

- ;;

- *)

- echo "usage: $0 {start|stop}"

- exit 1

- esac

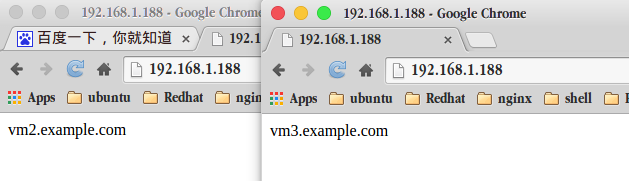

测试的时候我们在real server里面设置一个发布页面进行测试

echo `hostname` >/var/www/html/index.html

然后就可以进行测试了!

tips: -g 表示使用dr方式,-m表示nat方式,-i表示tunneling方式。

lvs 三种工作模式的优缺点比较:

一、virtual server via nat(vs-nat)

优点:集群中的物理服务器可以使用任何支持tcp/ip操作系统,物理服务器可以分配internet的保留私有地址,只有负载均衡器需要一个合法的ip地址。

缺点:扩展性有限。当服务器节点(普通pc服务器)数据增长到20个或更多时,负载均衡器将成为整个系统的瓶颈,因为所有的请求包和应答包都需要经过负载均衡器再生。假使tcp包的平均长度是536字节的话,平均包再生延迟时间大约为60us(在pentium处理器上计算的,采用更快的处理器将使得这个延迟时间变短),负载均衡器的最大容许能力为8.93m/s,假定每台物理服务器的平台容许能力为400k/s来计算,负责均衡器能为22台物理服务器计算。

解决办法:即使是是负载均衡器成为整个系统的瓶颈,如果是这样也有两种方法来解决它。一种是混合处理,另一种是采用virtual server via ip tunneling或virtual server via direct routing。如果采用混合处理的方法,将需要许多同属单一的rr dns域。你采用virtual server via ip tunneling或virtual server via direct routing以获得更好的可扩展性。也可以嵌套使用负载均衡器,在最前端的是vs-tunneling或vs-drouting的负载均衡器,然后后面采用vs-nat的负载均衡器。

二、virtual server via ip tunneling(vs-tun)

我们发现,许多internet服务(例如web服务器)的请求包很短小,而应答包通常很大。

优点:负载均衡器只负责将请求包分发给物理服务器,而物理服务器将应答包直接发给用户。所以,负载均衡器能处理很巨大的请求量,这种方式,一台负载均衡能为超过100台的物理服务器服务,负载均衡器不再是系统的瓶颈。使用vs-tun方式,如果你的负载均衡器拥有100m的全双工网卡的话,就能使得整个virtual server能达到1g的吞吐量。

不足:但是,这种方式需要所有的服务器支持"ip tunneling"(ip encapsulation)协议,我仅在linux系统上实现了这个,如果你能让其它操作系统支持,还在探索之中。

三、virtual server via direct routing(vs-dr)

优点:和vs-tun一样,负载均衡器也只是分发请求,应答包通过单独的路由方法返回给客户端。与vs-tun相比,vs-dr这种实现方式不需要隧道结构,因此可以使用大多数操作系统做为物理服务器,其中包括:linux 2.0.36、2.2.9、2.2.10、2.2.12;solaris 2.5.1、2.6、2.7;freebsd 3.1、3.2、3.3;nt4.0无需打补丁;irix 6.5;hpux11等。

不足:要求负载均衡器的网卡必须与物理网卡在一个物理段上

参考: