- 博客访问: 1637559

- 博文数量: 63

- 博客积分: 0

- 博客等级: 民兵

- 技术积分: 646

- 用 户 组: 普通用户

- 注册时间: 2015-05-26 18:02

个人简介

祸兮福之所倚,福兮祸之所伏

文章分类

相关博文

- ·

- ·

- ·

- ·

- ·

- ·

- ·

- ·

- ·

- ·

分类: 系统运维

2015-07-28 23:39:15

rhcs是红帽架构标准,rhcs的核心组件为cman和rgmanager,其中cman为基于openais的“集群基础架构层”,rgmanager为资源管理器。rhcs的集群中资源的配置需要修改其主配置文件/etc/cluster/cluster.xml实现,这对于很多用户来说是比较有挑战性的,因此,rhel提供了system-config-cluster这个gui工具,其仅安装在集群中的某一节点上即可,而cman和rgmanager需要分别安装在集群中的每个节点上。

测试环境:三个节点

node1.test.com 192.168.1.121

node2.test.com 192.168.1.122

node3.test.com 192.168.1.123

系统都为centos 6.6 64位

测试服务为apache的httpd服务(其他都差不多)

开始配置前提

在三台主机/etc/hosts 写入

node1.test.com 192.168.1.121

node2.test.com 192.168.1.122

node3.test.com 192.168.1.123

做主机名修改

#修改/etc/sysconfig/network中hostname值改为相应主机名

# hostname node1.test.com

设置免密码使用ssh命令远程执行命令

[root@node1 ~]# ssh-keygen

generating public/private rsa key pair.

enter file in which to save the key (/root/.ssh/id_rsa):

/root/.ssh/id_rsa already exists.

overwrite (y/n)? y

enter passphrase (empty for no passphrase):

enter same passphrase again:

your identification has been saved in /root/.ssh/id_rsa.

your public key has been saved in /root/.ssh/id_rsa.pub.

the key fingerprint is:

fe:80:77:52:97:a4:97:60:51:81:16:e2:a3:83:45:60 root@node1

the key's randomart image is:

--[ rsa 2048]----

| e.. . o o. |

| . . . .o. |

| . o.o . |

| o . o o |

| . o s o = |

| . o |

| . = . |

| . = |

| . |

-----------------

[root@node1 ~]# ssh-copy-id node2

root@node2's password:

now try logging into the machine, with "ssh 'node2'", and check in:

.ssh/authorized_keys

to make sure we haven't added extra keys that you weren't expecting.

照样对node3执行一遍

从此可以免密码直接使用ssh登录node2和node3主机

为三个节点安装组件cman rgmanager

for i in {1..3}; do ssh node$i 'yum -y install cman rgmanager system-config-cluster'; done

分别启动三个节点服务

for i in {1..3}; do ssh node$i 'service cman start service rgmanager start'; done

rhcs的配置文件/etc/cluster/cluster.conf,其在每个节点上都必须有一份,且内容均相同,其默认不存在,因此需要事先创建,ccs_tool命令可以完成此任务。另外,每个集群通过集群id来标识自身,因此,在创建集群配置文件时需要为其选定一个集群名称,这里假设其为cluster。此命令需要在集群中的某个节点上执行。

首先创建一个集群名称,主要是让其自动创建cluster.conf文件

[root@node1 ~]# ccs_tool create cluster

一个rhcs集群至少需要一个fence设备,正常环境中,可以选择将其配置到集群中来。这里为演示环境,没有可用的fence设备,因此,选择使用“manual fence”,即手动fence。创建fence设备也需要使用ccs_tool命令进行,其需要在集群中的某节点上执行,而且需要与前面创建集群配置文件时所执行的命令在同一个节点上进行。

[root@node1 ~]# ccs_tool addfence meatefence fence-manual

[root@node1 ~]# ccs_tool lsfence

name agent

meatefence fence-manual

增加节点

[root@node1 ~]# ccs_tool addnode -n 1 -f meatefence node1.test.com

[root@node1 ~]# ccs_tool addnode -n 2 -f meatefence node2.test.com

[root@node1 ~]# ccs_tool addnode -n 3 -f meatefence node3.test.com

[root@node1 ~]# ccs_tool lsnode

cluster name: cluster, config_version: 5

nodename votes nodeid fencetype

node1.test.com 1 1 meatefence

node2.test.com 1 2 meatefence

node3.test.com 1 3 meatefence

这时候需要手动把配置文件复制到各个节点for i in {1..3};do ssh node$i "scp /etc/cluster/cluster.conf node2:/etc/cluster";done

分别启动集群服务

service cman start

查看节点状态

[root@node1 ~]# clustat

cluster status for cluster @ tue jul 28 08:09:09 2015

member status: quorate

member name id status

------ ---- ---- ------

node1 1 online, local

node2 2 online

node3 3 online

配置成功

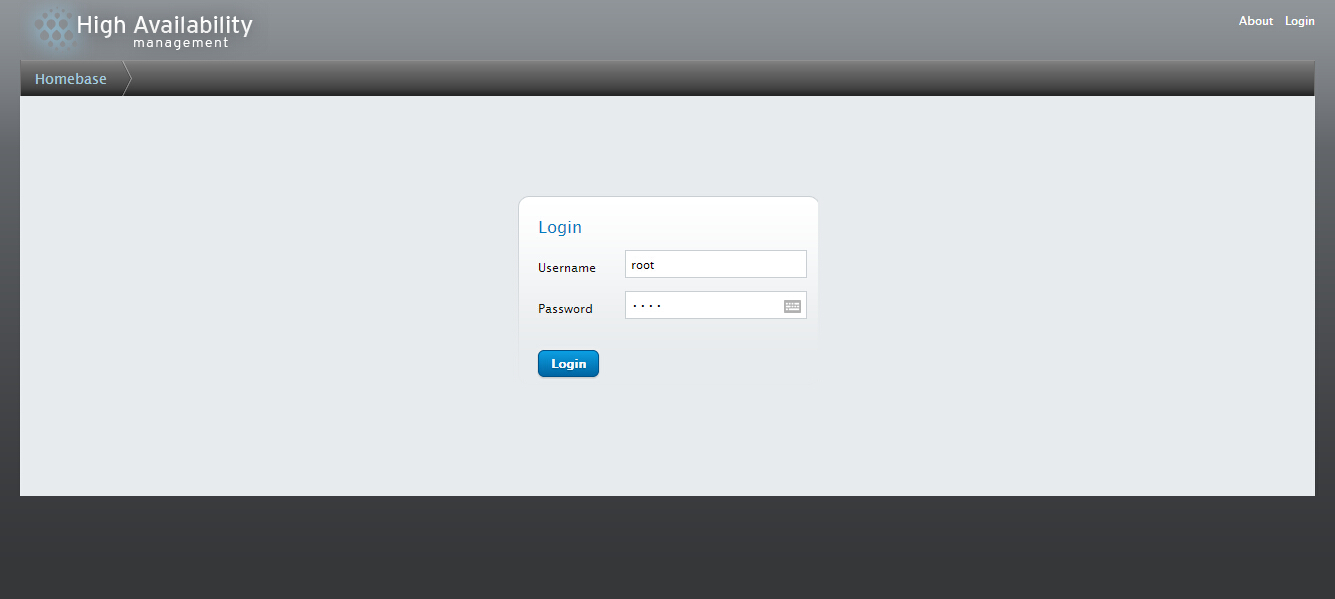

在红帽6以后版本可通过ricci和luci进行web界面对服务集群服务状态进行管理

ricci是通信端。luci是管理端

三个节点都安装ricci,管理端安装好luci,分别启动

tcp 0 0 :::11111 :::* listen 3448/ricci

节点间通信是通过tcp11111端口

[root@node1 ~]# /etc/init.d/luci start

starting saslauthd: [ ok ]

start luci... [ ok ]

point your web browser to (or equivalent) to access luci

tcp 0 0 0.0.0.0:8084 0.0.0.0:* listen 3369/python

管理端是通过tcp8084管理

浏览器输入

输入用户名密码root

登录后就可以对集群进行相应的管理和操作了

不知道怎么图片就无法上传。

至此rhcs的一个集群就已经构建完成,可以在上面增加集群,配置服务组等等。rhcs本身是属于高可用的集群也是可以做资源自动转移等功能。

测试环境:三个节点

node1.test.com 192.168.1.121

node2.test.com 192.168.1.122

node3.test.com 192.168.1.123

系统都为centos 6.6 64位

测试服务为apache的httpd服务(其他都差不多)

开始配置前提

在三台主机/etc/hosts 写入

node1.test.com 192.168.1.121

node2.test.com 192.168.1.122

node3.test.com 192.168.1.123

做主机名修改

#修改/etc/sysconfig/network中hostname值改为相应主机名

# hostname node1.test.com

设置免密码使用ssh命令远程执行命令

[root@node1 ~]# ssh-keygen

generating public/private rsa key pair.

enter file in which to save the key (/root/.ssh/id_rsa):

/root/.ssh/id_rsa already exists.

overwrite (y/n)? y

enter passphrase (empty for no passphrase):

enter same passphrase again:

your identification has been saved in /root/.ssh/id_rsa.

your public key has been saved in /root/.ssh/id_rsa.pub.

the key fingerprint is:

fe:80:77:52:97:a4:97:60:51:81:16:e2:a3:83:45:60 root@node1

the key's randomart image is:

--[ rsa 2048]----

| e.. . o o. |

| . . . .o. |

| . o.o . |

| o . o o |

| . o s o = |

| . o |

| . = . |

| . = |

| . |

-----------------

[root@node1 ~]# ssh-copy-id node2

root@node2's password:

now try logging into the machine, with "ssh 'node2'", and check in:

.ssh/authorized_keys

to make sure we haven't added extra keys that you weren't expecting.

照样对node3执行一遍

从此可以免密码直接使用ssh登录node2和node3主机

为三个节点安装组件cman rgmanager

for i in {1..3}; do ssh node$i 'yum -y install cman rgmanager system-config-cluster'; done

分别启动三个节点服务

for i in {1..3}; do ssh node$i 'service cman start service rgmanager start'; done

rhcs的配置文件/etc/cluster/cluster.conf,其在每个节点上都必须有一份,且内容均相同,其默认不存在,因此需要事先创建,ccs_tool命令可以完成此任务。另外,每个集群通过集群id来标识自身,因此,在创建集群配置文件时需要为其选定一个集群名称,这里假设其为cluster。此命令需要在集群中的某个节点上执行。

[root@node1 ~]# ccs_tool create cluster

一个rhcs集群至少需要一个fence设备,正常环境中,可以选择将其配置到集群中来。这里为演示环境,没有可用的fence设备,因此,选择使用“manual fence”,即手动fence。创建fence设备也需要使用ccs_tool命令进行,其需要在集群中的某节点上执行,而且需要与前面创建集群配置文件时所执行的命令在同一个节点上进行。

[root@node1 ~]# ccs_tool addfence meatefence fence-manual

[root@node1 ~]# ccs_tool lsfence

name agent

meatefence fence-manual

增加节点

[root@node1 ~]# ccs_tool addnode -n 1 -f meatefence node1.test.com

[root@node1 ~]# ccs_tool addnode -n 2 -f meatefence node2.test.com

[root@node1 ~]# ccs_tool addnode -n 3 -f meatefence node3.test.com

[root@node1 ~]# ccs_tool lsnode

cluster name: cluster, config_version: 5

nodename votes nodeid fencetype

node1.test.com 1 1 meatefence

node2.test.com 1 2 meatefence

node3.test.com 1 3 meatefence

这时候需要手动把配置文件复制到各个节点for i in {1..3};do ssh node$i "scp /etc/cluster/cluster.conf node2:/etc/cluster";done

分别启动集群服务

service cman start

查看节点状态

[root@node1 ~]# clustat

cluster status for cluster @ tue jul 28 08:09:09 2015

member status: quorate

member name id status

------ ---- ---- ------

node1 1 online, local

node2 2 online

node3 3 online

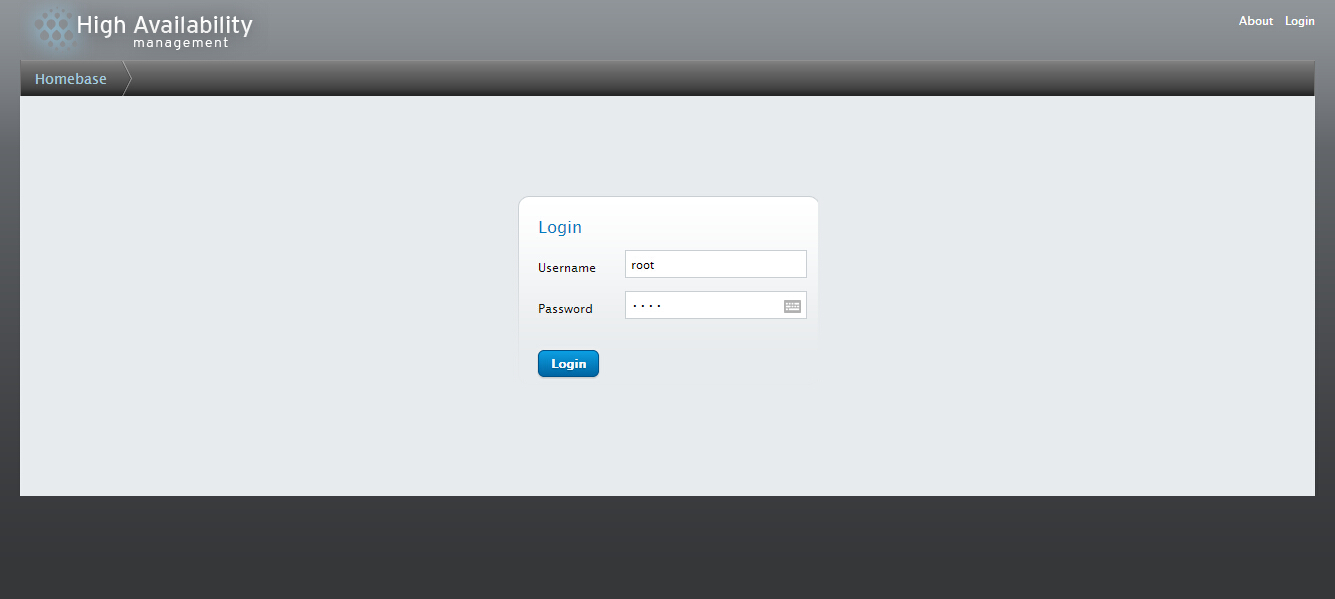

在红帽6以后版本可通过ricci和luci进行web界面对服务集群服务状态进行管理

ricci是通信端。luci是管理端

三个节点都安装ricci,管理端安装好luci,分别启动

tcp 0 0 :::11111 :::* listen 3448/ricci

节点间通信是通过tcp11111端口

[root@node1 ~]# /etc/init.d/luci start

starting saslauthd: [ ok ]

start luci... [ ok ]

point your web browser to (or equivalent) to access luci

tcp 0 0 0.0.0.0:8084 0.0.0.0:* listen 3369/python

管理端是通过tcp8084管理

浏览器输入

输入用户名密码root

登录后就可以对集群进行相应的管理和操作了

不知道怎么图片就无法上传。

至此rhcs的一个集群就已经构建完成,可以在上面增加集群,配置服务组等等。rhcs本身是属于高可用的集群也是可以做资源自动转移等功能。

给主人留下些什么吧!~~