天翼云是中国电信倾力打造的云服务品牌,致力于成为领先的云计算服务提供商。提供云主机、cdn、云电脑、大数据及ai等全线产品和场景化凯发app官方网站的解决方案。

- ·

- ·

- ·

- ·

- ·

- ·

- ·

- ·

- ·

- ·

分类: mysql/postgresql

2023-11-06 16:59:47

本文分享自天翼云开发者社区《》,作者:l****n

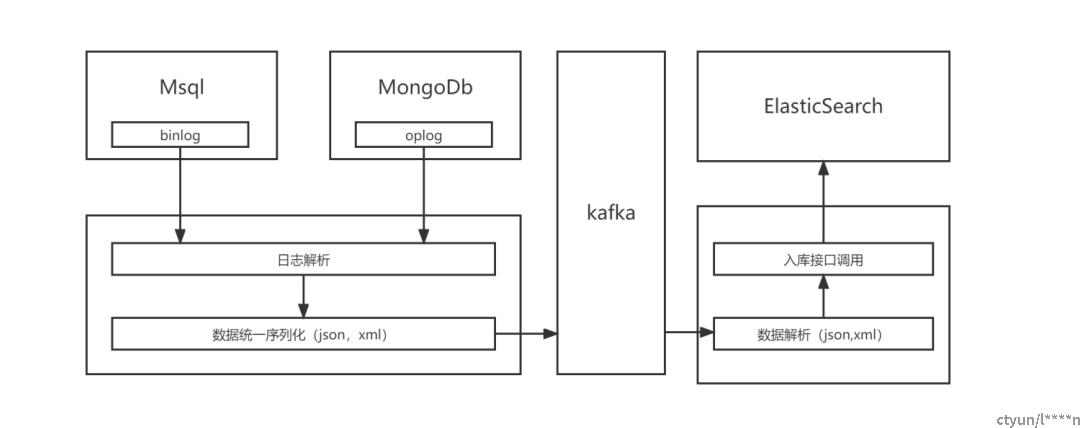

核心流程如下:

核心逻辑说明:

mysql binlog解析:

首先,从mysql的二进制日志(binlog)中解析出表名。这一步骤非常关键,因为我们只关注特定表的数据变更。

进一步,我们检查binlog中的操作类型,如insert、update和delete,以确定是否是表数据的变动操作。这是因为我们只需要捕获数据的变更,而不关心查询操作。

如果操作是insert或delete,我们只需要关注受影响的数据行。对于update操作,我们需要记录新旧值的变化。

内存中数据组装:

从解析过的binlog数据中,我们构建一个内存数据结构,通常是一个数据对象,其中包括表名、字段名、新旧值等信息。这允许我们在内存中轻松管理和处理数据。

数据序列化:

接下来,我们将内存中的数据对象序列化为特定的格式,通常为json或xml。这是为了将数据转化为一种可传输的结构,其中包含了表名、字段名和相应的新旧值。序列化的过程使数据适合通过网络传输。

数据传输到消息队列:

完成序列化后,数据通过tcp协议发送到消息队列,通常是apache kafka。消息队列用于持久性存储和传递数据,以确保数据不会丢失。

数据在消息队列中等待被消费者处理,这可以是其他系统、应用程序或服务,根据需要对数据进行进一步的分析或存储。

mongodb oplog解析:

mongodb的日志解析过程类似于mysql,但我们使用的是mongodb的操作日志(oplog)来捕获数据变更。

同样,我们从oplog中解析出表名,确定操作类型(insert、update、delete),并提取新旧值。

数据消费和存储:

消费者通过tcp协议从kafka队列中拉取数据。消费者可以是各种类型的应用程序或服务,例如数据仓库、实时监控系统等。

数据可以通过http协议将其写入elasticsearch,以进行搜索、分析和可视化。elasticsearch是一个强大的搜索引擎和分析工具,适用于处理大量数据。

以上流程描述了如何从mysql和mongodb中的日志解析数据,将其序列化为可传输的格式,并通过消息队列传递到其他系统或存储库中,以便进行后续处理、分析和查询。这种数据管道允许实时捕获和利用数据库中的变更,以满足各种用例和需求。